動画生成AI「RunwayML」で、「ロミオとジュリエット」の予告風ムービーを作ってみた。動画は、記事本編の3ページ目を見てほしい。以下、記事中の動画・静止画はすべて筆者がAIで制作したもの

動画生成AI「RunwayML」で、「ロミオとジュリエット」の予告風ムービーを作ってみた。動画は、記事本編の3ページ目を見てほしい。以下、記事中の動画・静止画はすべて筆者がAIで制作したもの

MidjorneyAIやStableDiffusionといった生成AIを使った美女画像がネットにあふれる昨今、「AIで静止画が作れる」ということは広く一般に認知されるようになった。無料でサービス提供されているマイクロソフトのBing Image Creatorなどを利用し、身近に使えるものだと感じた人もいるだろう。一方、先端的なAI企業は、静止画生成の次のステップとして動画生成技術の完成度を高めようとしている。すでに、ジェスチャーを交えながら合成とは思えない自然な声色でナレーションを読み上げるAIアバターは、製品のプロモーションビデオやプレゼンテーションで普通に使われるようになった。しかし、動画生成AIの当面の目標は、静止画の場合と同様に、テキストや既存データを元に、説得力のある映像を自動で作り上げることだ。今回は、WebやiOSアプリで手軽に試せる「RunwayML」というツールを使って、その最前線をのぞいてみよう。動画生成AIは、ここまで手軽に使える存在になってきているのかと驚くはずだ。(テクノロジーライター 大谷和利)

動画生成AIのRunwayMLを使い、

実写動画からクレイアニメを作ってみる

生成AIの世界では、(静止)画像生成AIにサードパーティーの拡張機能を付加して動画生成を行うプロセスが確立しつつある。しかし、かなりのマシンパワーを要したり、細かなセッティングを行ったりする必要があり、そこまでしても滑らかな動画を作り出すのはなかなか難しいのが現状だ。

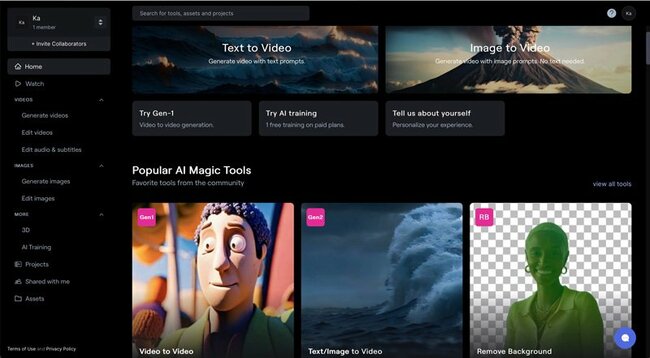

その点、RunwayML(https://app.runwayml.com/)は、Webブラウザから簡単にアクセスして試すことができ、テキスト(プロンプト)、ビデオ、イメージの3通りの指示方法によって、そこそこ質の高い動画を生成することが可能である。また、iPhoneやiPadユーザーであれば、アプリストアから同名のアプリをインストールして使うこともできる。

筆者は、静止画の画像生成AIではMidjourney AIがトップレベルにあると考えているが、RunwayMLはまだ発展途上とはいえ、先進性の点では動画生成におけるMidjourney AI的な位置付けと言ってよさそうだ。無料プランでは125クレジット(使い切り)、有料プランでは625クレジット(毎月追加)、または2250クレジット(同)が付与され、Gen-1の機能(動画から動画を作る)は1秒あたり14クレジット、Gen-2の機能(テキストから動画を作る、または、静止画から動画を作る)は1秒あたり5クレジットを消費する。また、生成1回あたりの動画の長さは最大4秒となっている(有料プランのVideo to Videoは、最大15秒まで)。

RunwayMLは、動画生成におけるMidjourney AI的な位置付け。ジャンルにもよるが、テキスト、ビデオ、イメージから、かなり優秀な動画を作り出すことができ、Webアプリのほか、iOSアプリもある 拡大画像表示

RunwayMLは、動画生成におけるMidjourney AI的な位置付け。ジャンルにもよるが、テキスト、ビデオ、イメージから、かなり優秀な動画を作り出すことができ、Webアプリのほか、iOSアプリもある 拡大画像表示

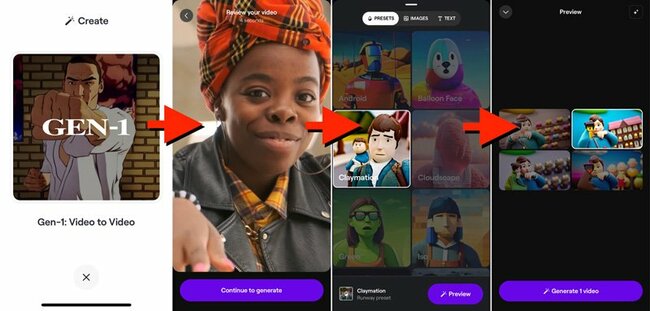

もし、すでに撮影済みの実写動画などがあるなら、RunwayMLを利用する最も簡単な方法は、Gen-1のVideo to Video機能を使って、動画のスタイルを変更することだ。生成AIの登場以前にも、動画を油絵風や水彩画風、スケッチ風などに変換するアプリは存在したが、それらはあくまでもテクスチャー表現レベルの加工であり、全体的なイメージは元の雰囲気を維持していた。しかし、動画生成AIの場合には表層的な変更ではなく、実際に被写体は何か、どのような動きを伴っているか、背景には何が写っているか……などの情報が解析され、その上で、改めて指定されたスタイルの動画を作り出す仕組みになっている。

スタイルには、SF風、メタル風、スペース風、未来風、クレイメーション(粘土細工によるコマ撮りアニメーション)風など24種が用意され、動画生成の前に選んだスタイルに基づく静止画のプレビューが4パターン提示される。その一つを適宜選択して、実際の動画生成を行うことになる。ここでは分かりやすい例として、ソロダンスの動画を、クレイメーションのスタイルで変換してみた。生成結果の動画を見ると、基本的な動きを維持しつつも、人物や背景などが粘土細工的なイメージで置き換えられていることがわかる。

すでに元になるビデオがあれば、Gen-1のVideo to Videoの生成モードを利用できる。基本的には、変換したいビデオを選択し、変換後のスタイルを選び、プレビューの四つの静止画からイメージに近いものをセレクトして生成する 拡大画像表示

すでに元になるビデオがあれば、Gen-1のVideo to Videoの生成モードを利用できる。基本的には、変換したいビデオを選択し、変換後のスタイルを選び、プレビューの四つの静止画からイメージに近いものをセレクトして生成する 拡大画像表示