了解しました。先ほどの「上層部が出しそうなダメ出し・懸念」に対して、“大企業の意思決定を前に進めるための打ち手”を体系的に提示します。

1. 炎上・誤投稿などレピュテーションリスクへの打ち手

① 投稿前の二段階ガバナンス(AI→人間の承認)

・完全自動ではなく、「AIが草案→人が承認」という“セミ自動構造”にする。

・上層部にとって「ヒヤッとする要素」を消せる。

② ブランドガイドライン学習モジュール

・トーン&マナー、NGワード、禁止テーマを“学習データ化”し、AIが逸脱しない仕組みを提示。

③ 異常値検知(投稿内容・タイミングの監視)

・炎上ワード、政治・宗教などのセンシティブ領域は投稿自動停止。

2. ブランドトーンのブレ防止(品質対策)

④ AIの「ブランド別キャラ生成」

・企業ごとに“人格設定(Brand Persona)”を行い、文体・語彙を固定化。

・「ブランドの空気が変わる」懸念を解消。

⑤ 過去投稿の学習と文体模倣

・過去1~2年の投稿データを学習させることで、“そのブランドが書きそうな文章”しか出ない仕組みを構築。

3. 法務・コンプラ対策(大企業が最も気にする領域)

⑥ 生成画像の権利クリアを明示

・画像生成AIのライセンス明記

・権利侵害チェック(重複画像検出、著名人類似度チェック)

→ 法務部の懸念を最小化。

⑦ DM返信の範囲を“第一段階のみ”に限定

・深刻なクレームや個別相談は即エスカレーション。

・CS領域を侵さず、責任交錯を防止。

4. ROI(投資対効果)への打ち手

⑧ AI導入前後でのKPI比較ダッシュボード

・投稿数、エンゲージメント率、広告費削減額、運用工数削減などを可視化。

・上層部が最重視する“数字での説得材料”になる。

⑨ 小規模アカウントでの実証実験

・まずは1ブランド・1部門・新規の小アカウントで試験運用。

・リスク低くROIを可視化してから全社展開の判断へ。

5. 依存性・API変更リスクへの打ち手

⑩ マルチプラットフォーム対応

・X / Instagram / TikTok / Threads など複数APIに対応し、特定プラットフォーム依存のリスクを下げる。

⑪ 投稿不可時の“代替ルート”(手動切替)

・API制限があっても手動投稿へ即切替できる設計。

・「止まる」状態を避けられる。

6. 社内調整コストの削減

⑫ 業務フロー図を“絵で”提示する

・人がどのタイミングで関与し、どこが自動化されるのかを視覚化することで、マーケ・広報・法務の共通認識が揃いやすい。

⑬ 役割分担の明確化(AI・担当者・広報・CS)

・AIは一次対応まで

・担当者は承認

・広報はトーン管理

・CSはクレーム対応

→ これで責任所在が明確になる。

7. 炎上発生時の責任問題への打ち手

⑭ “自動停止&即エスカレーション”フロー

・不適切ワード・炎上兆候をトリガーに「AIが投稿停止 → 担当者へアラート」

・「AIが暴走したらどうするのか」という根源的な懸念への回答。

⑮ 事故発生時の“再発防止テンプレート”

・不具合→原因分析→禁止ルール追加

・毎回AIが賢くなる構造を保証。

まとめ:上層部を納得させる“落としどころ”はこれ

・完全自動ではなく、“人の判断を残した半自動化”から段階的に進める。

そして、

・ブランド保護

・ガバナンス

・ROI

・社内調整容易性

・リスク発生時の責任所在

の疑念を一つずつ潰すことで、導入の筋道が通ります。

いくつかの打ち手が、単なる対症療法ではなく、大企業の意思決定構造を的確に踏まえた本質的な整理になっていて感心しました。

「小規模アカウントでの実証実験(PoC運用)」

これは非常に上手いですね。大企業の上層部は、リスクをゼロにできない限り前に進まない傾向がありますが、“限定環境で実績をつくってから広げる”という手順は、組織文化そのものにフィットする進め方です。

特にSNS運用のように影響範囲が広い領域では、まずは小規模での成功事例が導入判断の引き金になりやすい。社内説得のための“布石”として非常に理にかなっていると感じました。

「AI→人間承認の二段階ガバナンス」

これも実に現実的な打ち手です。完全自動は魅力的ですが、大企業では「責任の所在が明確であること」が最優先される。その点、二段階承認は「品質の担保」「炎上リスクの制御」「法務・広報の安心感」を同時に満たす、極めて合理的な落としどころです。

自動化の便益とガバナンスの要請を両立させた設計として評価できます。

「DM返信の範囲を一次対応だけに限定する」

これはCS領域との摩擦を避ける意味で非常に重要です。多くの企業で、SNSとCSは管轄が異なり、境界が曖昧なまま運用すると必ずトラブルが起きます。

“AIは最初の反応まで。深刻案件は人へ”という線引きは、運用責任・業務領域・ブランド保護のすべてを整えるための本質的なルール化です。

これらの打ち手は、単にリスクを潰すためのものではなく、「上層部が意思決定できる状態をつくる」という視点に立った、非常に質の高い対策になっていると感じました。

技法その31「ダメ出しの模擬」、ぜひ活用してみてください。

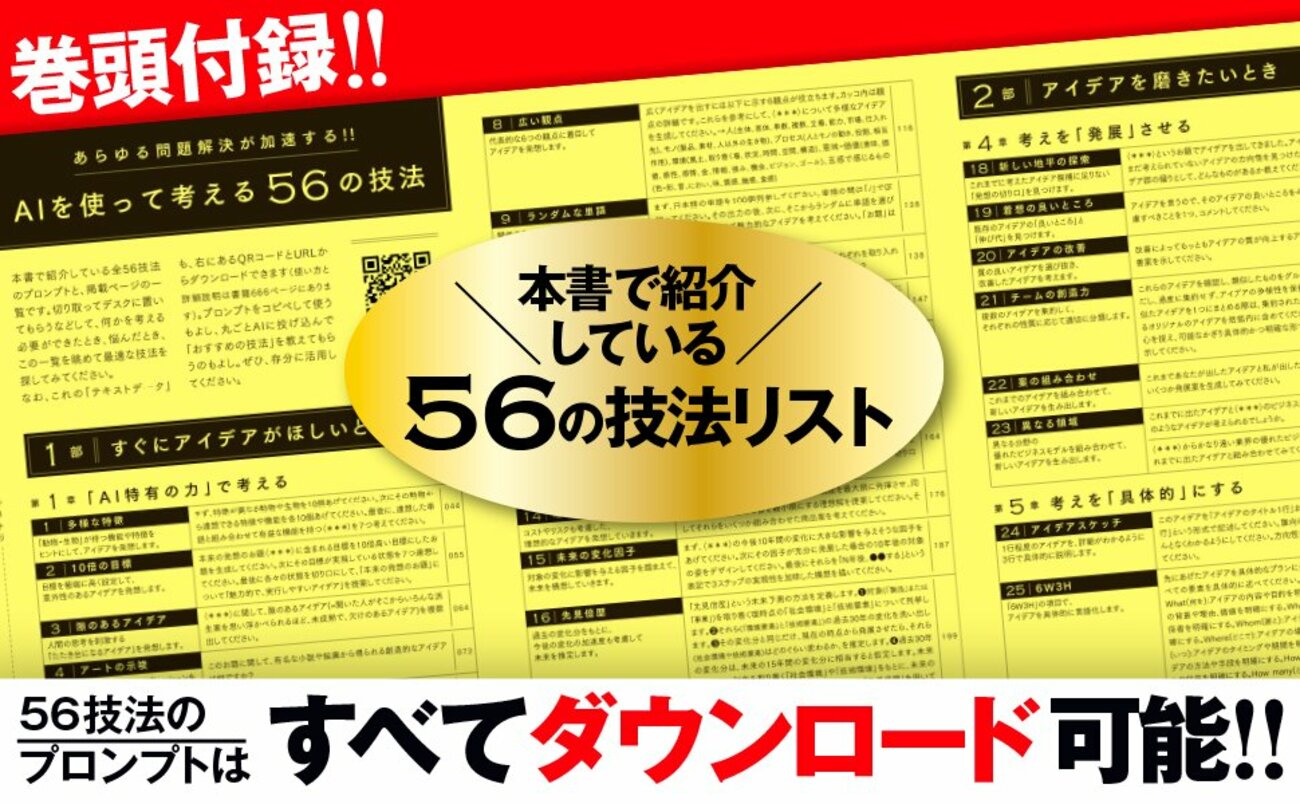

(本稿は、書籍『AIを使って考えるための全技術』の内容を一部抜粋・編集して作成した記事です。この他にも書籍では、AIを使って思考の質を高める56の方法を紹介しています)