ChatGPTがローンチされてから丸2年が経った。仕事上の文書作成やアイデア出しに、生成AIを活用している人は少なくないが、「データが漏洩するのが怖い」「嘘の回答をするのではないか」といった不安の声も聞かれる。

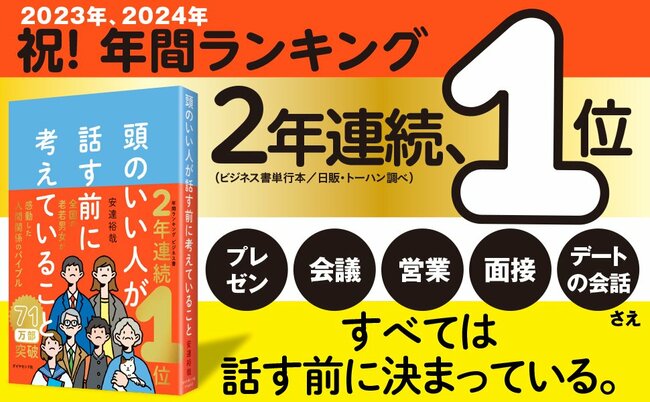

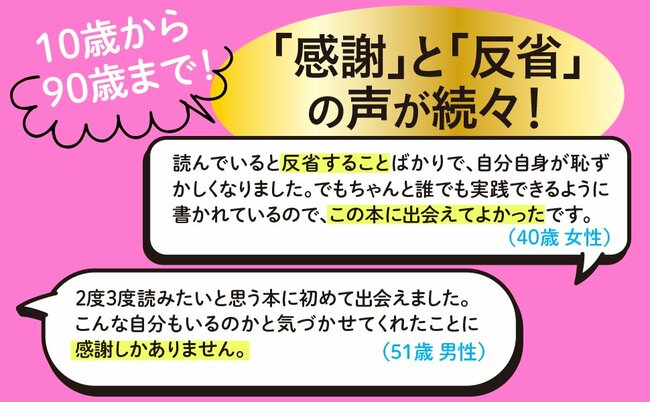

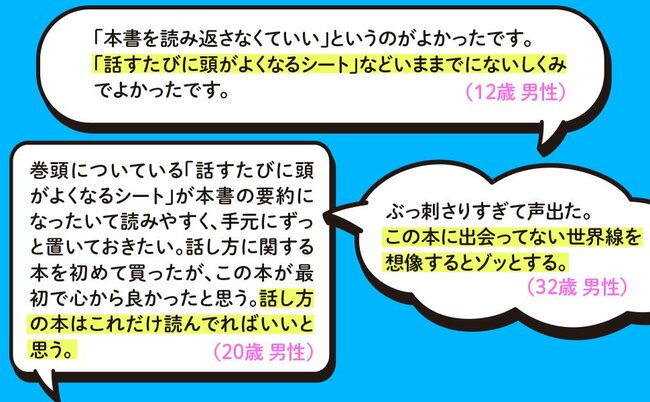

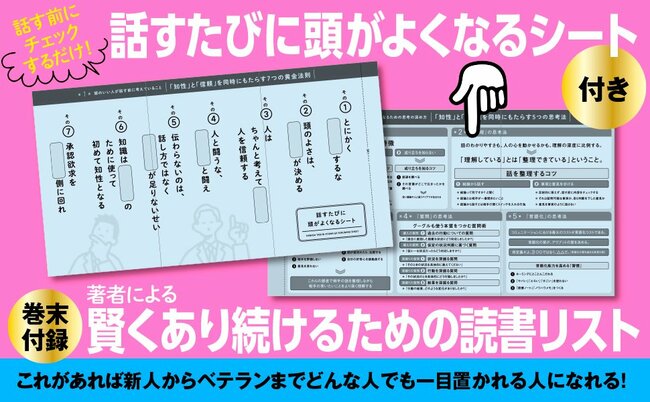

そこで今回は、2024年・2023年ベストセラーランキングビジネス書部門で1位(日販/トーハン調べ)となり、「もっと早く読んでいればと後悔すらした」「ぶっ刺さりすぎて声出た」と反響を呼び続けている『頭のいい人が話す前に考えていること』の著者・安達裕哉さんと、『「言葉にできる」は武器になる。』の著者・梅田悟司さんに、生成AIを使う際の注意点について語っていただいた。(構成/ダイヤモンド社コンテンツビジネス部)

Photo:Adobe Stock

Photo:Adobe Stock

学習対象になったら困る」という悩みを解消する方法

安達裕哉(以下、安達) 生成AIを使うメリットは多々ありますが、世間では不安の声も聞かれます。

梅田悟司(以下、梅田) 代表的なのは、「データが漏洩するのではないか」「自分が入力した内容が学習対象にされたら困る」といったものですよね。

実際、ChatGPTが出始めた頃にかなり話題になりましたし、その印象が残っている方々も多いと思います。

安達 ChatGPTの利用をためらっている人や、使用を禁止している組織は、この点を相当気にしているはずです。ただ、実はわりと簡単に、学習対象から除外してもらうことができます。

まず、ChatGPTのサービスのなかで、個人で使うプランを選ぶと、学習の対象になる恐れがあるのは事実です。一方で、チームプランや法人向けプランに入ると、学習対象から除外されます。なので、企業で導入したいときは、こうしたプランを検討するといいと思います。

さらに、個人で使うケースでも、以下の手順で学習対象から外してもらえます。

1)OpenAIのプライバシーリクエストポータルのページにアクセス

2)「プライバシーリクエストを送信する」というボタンを押す

3)「私のコンテンツでトレーニングをしないでください」というボタンを押す

4)Eメールアドレスを入力して送信

5)メールに届いたリンクから、学習対象からの除外をリクエスト

「AIに嘘をつかれる」のを防ぐ方法

安達 もう1つよく取り上げられるのが、「生成AIが嘘を教えるのではないか」という懸念です。

梅田 いわゆる「ハルシネーション問題」ですね。

安達 そうですね。私も、記事の構成を練るときなどに生成AIを活用しますが、「虚偽の回答をしていないだろうか」と心配になることがあります。

事実に基づかない回答が出てくるのを防ぐには、どうすればいいでしょうか?

梅田 生成AIのAPI(※)には、0.0~2.0までの「温度設定」というのがあって、数値が低いほど厳密な作業を行い、数値が高いほどクリエイティブな作業をするようになっています。デフォルト値は1.0に設定されているはずです。

API上では、自分で温度設定を変えられますが、一般の人がそれをやるのは技術的にハードルが高いと思います。一方で、ブラウザ版だと温度設定は変えられません。

安達 では、ハルシネーションは防ぎようがないのでしょうか?

梅田 いえ、実はブラウザ版であっても、プロンプト(※)を工夫すれば疑似的に温度設定ができるんです。

たとえば、プロンプトの中に「科学的根拠を教えてください」「感情や憶測を含まず、事実に基づく回答をしてください」「出典を明示してください」といった言葉を含めることで、正確なアウトプットを引き出すことができます。

安達 なるほど。言葉で明確に厳密さを要求することで、ハルシネーションを起きにくくするんですね。

梅田 その通りです。温度設定そのものは変えられなくても、的確なプロンプトで疑似的に温度設定を下げられるということです。

逆に、正確さよりも創造性を求めるなら、「自由に考えてください」という指示が有効です。場面によってプロンプトの使い分けができれば、利便性がグッと上がりますよ。

(本稿は、『頭のいい人が話す前に考えていること』の著者・安達裕哉氏の対談記事です)

Books&Apps運営、企業コンサルティング

Deloitteにて12年間コンサルティングに従事。大企業、中小企業あわせて1000社以上に訪問し、8000人以上のビジネスパーソンとともに仕事をする。仕事、マネジメントに関するメディア『Books&Apps』を運営する一方で、企業の現場でコンサルティング活動を行う。著書に、2024年上半期・2023年ベストセラーランキングビジネス書部門で1位(日販/トーハン調べ)となった『頭のいい人が話す前に考えていること』(ダイヤモンド社)など。