AIボイスクローン~3年前からすでに警鐘は鳴らされていた

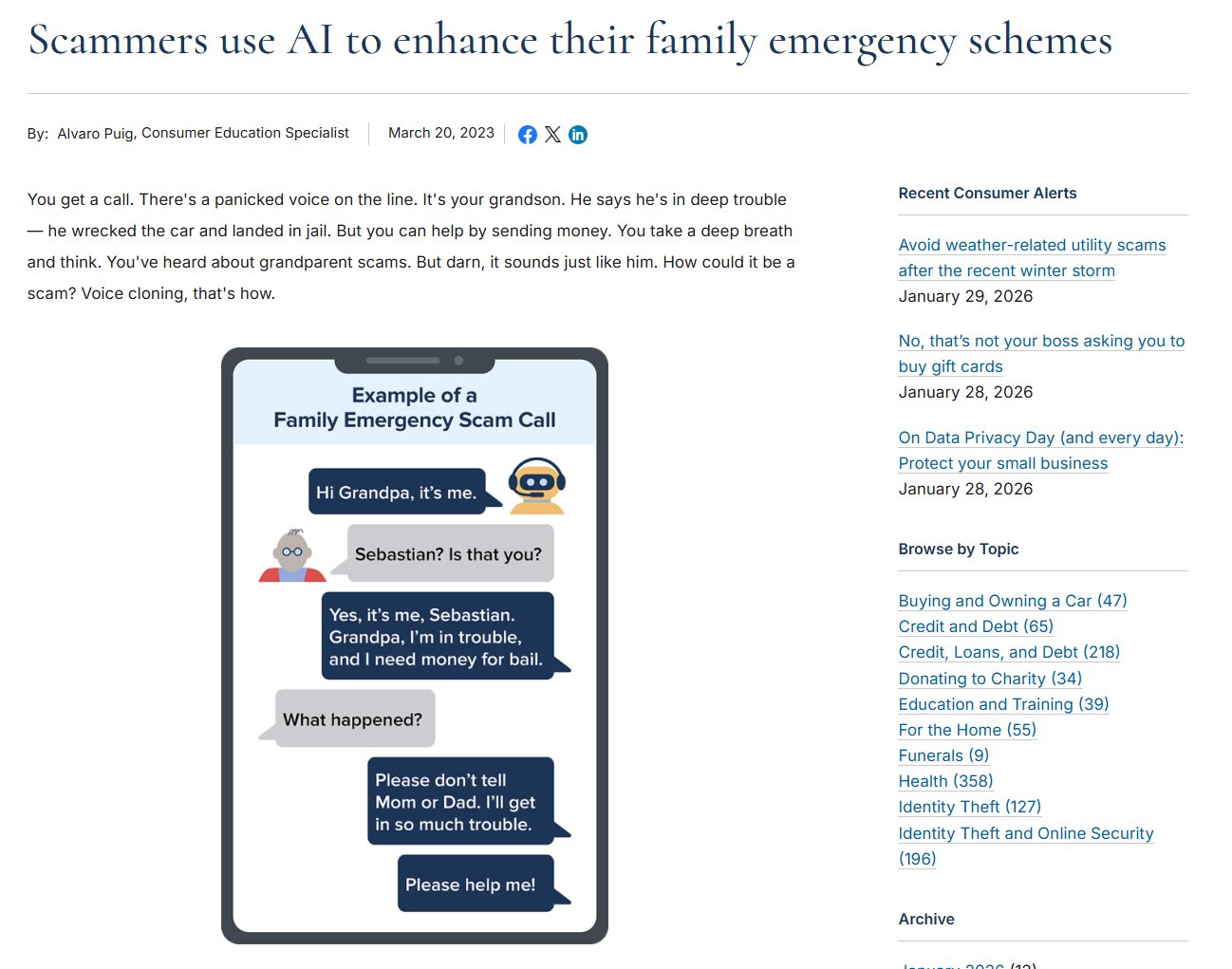

AIを使った「音声クローン犯罪」については、数年前から警告が出ていた。米国では2023年3月、FTC(米連邦取引委員会)がすでに以下のような注意喚起を公開している。「AIボイスクローニング(音声複製)」を悪用した、従来のオレオレ詐欺の巧妙化についての警告だ。

従来の「孫を装うオレオレ詐欺」では、受け手が「本当に孫の声か?」と疑う余地があった。しかし今やAIで本人の声をそっくりに複製できるため、その疑念すら持ちにくくなっている。

犯人は本人の短い動画(SNSなどに投稿された、数秒から数十秒の動画でいい)から音声サンプルを抽出し、それをAIソフトに取り込むだけで、その人特有の話し方や声色を再現した「クローン音声」を自由に発話させることができる。「交通事故を起こした」「逮捕された」「強盗に遭った」などのセリフをしゃべらせ、パニック状態を演出し、被害者の冷静な判断を奪う。声が本人そっくりなだけに、信じ込んでしまう被害者が後を絶たない。

FTCは対策として、次の3点を挙げている。

(2)「支払方法に注目」:銀行振込、暗号資産、ギフトカードでの支払いを要求されたら詐欺を疑う。

(3)「合言葉を決めておく」:家族間だけで通じる緊急時の合言葉を事前に決めておく。

「もしもし」の3秒でクローンが完成する時代

2023年当時、AIボイスクローニングには相応の計算リソースとスキルが必要だった。また、音声サンプルも「少なくとも30秒~数分のクリアな音声」が必要とされており、WebサイトやYouTubeのスピーチ動画、インタビュー動画などから音声を拾うのが一般的だった。

だが2026年現在、状況は劇的に変わっている。スマホアプリ1つで、わずか数秒のサンプルからリアルタイムに声を変換できるようになった。RVCの進化版やSpeech-to-Speech基盤モデルでは、わずか3秒程度の音声サンプルがあれば、イントネーションや感情の起伏まで含めたクローン生成が可能だ。

これは何を意味するか。たとえば「間違い電話」を装って電話をかけ、「もしもし? どなたですか? もしもし?」――これだけで約3秒。クローン作成に十分なデータが採取できてしまうのだ。