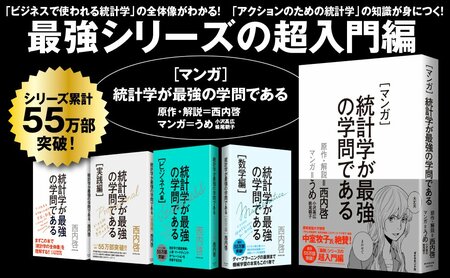

統計学の解説書ながら42万部超えの異例のロングセラーとなっている『統計学が最強の学問である』。そのメッセージと知見の重要性は、統計学に支えられるAIが広く使われるようになった今、さらに増しています。そしてこのたび、ついに同書をベースにした『マンガ 統計学が最強の学問である』が発売されました。

第11回では、統計学やデータ分析における重要な概念である「誤差」や「p値」について解説します。(本記事は2013年に発行された『統計学が最強の学問である』を一部改変し公開しています。)

Photo: Adobe Stock

Photo: Adobe Stock

「誤差」を考えない試算は皮算用

「60億円儲かる裏ワザ」の例では、単純なクロス集計から売上を増加させる可能性のある要因を明らかにし、またいくら売上が増加するのかといった額の試算も行なったが、これはあくまで皮算用だ。

なぜなら、この計算が「誤差」というものをまったく考慮していないからである。

フィッシャーたちの時代とそれ以前の統計学の大きな違いは、誤差の取扱い方にあると言っていい。データに対して、どれほどの誤差があるか、それは真に知りたい値に対してどれほどの影響を持つか、そして誤差を考慮したうえでも意味のある結果かどうか、といったことを明らかにできるようになったことがフィッシャーたちによる大きな功績である。

「60億円儲かる裏ワザ」のやり方で言えば、「DM送付群と非送付群の売上の違い」というのが真に関心のある値である。単純な推定としては500円違うと示されたが、この500円というのは誤差を含んだ値である。もしまた今後もデータをフォローアップして同じような検討を重ねたとしても、その差は300円だったり、1000円だったり、時には逆にDM非送付群の売上のほうが高くなったり、といった可能性だってあり得る。

そして最悪なケースなのは、本当はDM送付群と非送付群の間に売上の差などまったくないという状況で、たまたま誤差によって今回だけDM送付群の平均売上が高いという結果が得られてしまった場合である。あるいは、仮に差があったとしてもDM1通分のコストにさえならないという場合も考えられるかもしれない。こうした状況で誤って「DMを積極的に送る」といった戦略をとれば、DMのコスト分だけ丸損となってしまうのである。

「A/Bテスト」とはお馴染みの比較検討のこと

じつは以前示したような何の意味をなさない単純集計以外にも、こうした誤差を考えないクロス集計による皮算用、というのもビジネスの現場ではしばしば行なわれている。

たとえば私が以前統計学の講師として招かれたEC企業では、積極的に「A/Bテスト」を行なっている。クリックするバナーのサイズを変えたり、ページ間の画面遷移を変えたり、ページの文面やフォントを変えたり、といった細かいデザイン面や機能面の変更を行なううえで、「実際、どちらのデザインがよいのか」といった評価を検証しようというのだ。

参考までに「A/Bテスト」とは、デザインにせよ機能にせよ、AパターンとBパターンを両方試してみて比較する、という意味である。A/Bテストのためのツールやサービスというのは最近のシリコンバレーにおいても比較的ホットなトピックであるそうで、この分野において主要な地位を占めていたOmnitureという企業をAdobeが巨額を投じて買収したり、Google出身者でありオバマ大統領の選挙参謀でもあるダン・シロカーが立ち上げたOptimizelyという企業がその地位を脅かしたり、といった動向が注目を集めている。

多くの場合はユーザーのアクセスに対してランダムにAパターンとBパターンのサイトを開き、一定期間収集されたアクセスログをもとにAパターンとBパターンの比較を行なうことになる(ランダムに表示を分けることがむずかしい場合、1週間などの決まった期間ごとに表示を変えるという場合もある)。

比較されるのはたいていバナークリック率や商品の売上、有料会員への入会率といった利益に直結する数字についてであり、AパターンとBパターンのどちらが優れていたかという判断のもと、その後優れていたパターンがサイトに正式採用されるのだ。

なお、同時に3パターン以上試す場合についても「A/B/Cテスト」などとは呼ばれず、「A/Bテスト」と表現する。さらに余談だが統計学においてはこうしたデータの取り方のことを「A/Bテスト」とは言わずランダム化比較実験と呼ぶ(なおAパターンとBパターンの条件の変え方にランダムさが含まれていない実験は準実験と呼ぶ)。

「0.1%」の差は出たけれど

少し話がそれてしまったが、とにかくそのEC企業は力を入れて毎月のように細かいA/Bテストを行なっていた。コンマ数%のコンバージョン(購買率)の違いは年間にして億単位の売上に繋がると考えられたのだから、専任のチームを編成し、これまでの傾向から新たな改善パターンを考え続ける、というのは素晴らしい戦略である。

コンバージョンの上がる改善案を出したスタッフは定例のミーティングの中で賞賛され、実際に部署全体が祝福ムードに包まれていたそうである。データを経営に活かす姿勢として彼らの取り組みは素晴らしいものだ。

しかしながら、ここで落とし穴となるのが、彼らが誤差のことを考えていなかったという点である。

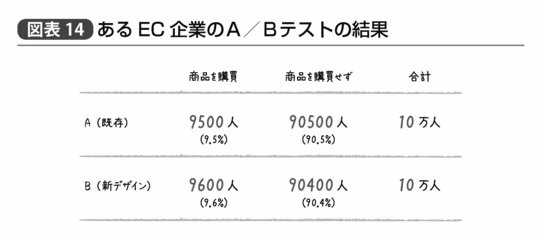

私が講師として参加した勉強会の後で、このA/Bテストを行なうチームのメンバーの1人から「自分たちのA/Bテストの結果も解析できるんでしょうか?」という質問をいただいた。彼女が見せてくれたのは図表14のような結果だ(実際のデータとは異なります)。

つまりサイト訪問者に対して、ランダムに既存のAパターンと改善したBパターンをそれぞれ10万人ずつに対して見せたログを分析した結果、既存パターンでは購買率が9.5%であったのに対し、デザインを改善した結果9.6%に伸びたというのである。

前節の考え方に則れば、こうした新しいデザインを採用するだけで売上は約1.01倍(=9.6%÷9.5%)に伸びるという可能性が示されたということである。つまりもし彼らに現在10億円の売上があったとすれば約1000万円、もし100億円の売上があったとすれば約1億円分の売上増加が見込まれるということだ。しかも何か特別の投資を行なうわけではなく、単にページの細かいデザインを変更しただけで、である。これなら確かに祝福ムードに包まれるのも不思議はない。

だが残念なことに、この差が意味のある差なのか、それとも誤差なのかはよくわからないのだ。

「カイ二乗検定」と「p値」の登場

こうしたクロス集計表について「意味のある偏り」なのか、それとも「誤差でもこれぐらいの差は生じるのか」といったことを確かめる解析手法に「カイ二乗検定」というものがある。

彼女が得たA/Bテストの結果に対してその場でカイ二乗検定を行なってみると、「実際には何の差もない状況でもデータの誤差によってこの程度(10万人中100人またはそれ以上)の差が生じる確率は44.7%である」という結果が示された。

この「実際には何の差もないのに誤差や偶然によってたまたまデータのような差(正確にはそれ以上に極端な差を含む)が生じる確率」のことを統計学の専門用語でp値という。

このp値が小さければ(慣例的には5%以下)、それに基づいて科学者たちは「この結果は偶然得られたとは考えにくい」と判断するというわけである。

5%以下であるべきp値が44.7%であるとは、つまり、彼女たちがデザインを褒めたり、チームで祝福していたりした結果が、真に今後何億円もの売上を約束するかどうかはまったくわからない、ということだ。

彼女たちが行なっていたことは、いわば、誰かがコインを1回投げて表が出たというだけで「すごい! 表が出続ける魔法のコインが見つかった!」とか、「すごい! この人はコインで表を出し続ける必勝法を身につけた!」と喜んでいる状態とまったく変わらないのだ。

本当に意味があったのかなかったのか、よくわからないまま定期的な改善を重ねて一喜一憂していても、彼女たちの仕事が利益に繋がっているのかはやはりよくわからない。

もちろん私は「これでは意味がある差かどうかわからない」ということだけでなく、「0.1%という小さな差であったとしても、もし実際に差があればきちんと統計学的に立証できるサンプルサイズ(とエクセルを使ったその計算方法)」についても彼女に伝えた。データのサンプルサイズを増やせば増やすほど誤差が小さくなるのは前に述べたところである。そして真の値として0.1%分の購買率の改善をデータによって実証したければ、およそそれぞれのパターンごとに延べ100万人ずつのデータがあればいい。

こうした計算も統計学を少し学べばすぐにできるようになるのである。

なお、彼女は別れ際に「今日学んだことが部署全体で共有できたら、業務プロセスどころか経営方針全体が変わるかもしれません」と言っていた。おそらく私もそうだろうと思う。この会社はデータを経営に活かすということについてかなり先進的な姿勢を持っていると思うが、それでも真に意味があるか判断のつきにくいA/Bテストを繰り返すという罠に陥っていたのだ。

誤差を理解し、誤差を考慮したうえでも意味がある結果といえるかどうか、という統計学の考え方を身につければ、こうした間違いから解放されることだろう。