AIが「使えるかどうか」は、人間側の「使い方」で決まります。

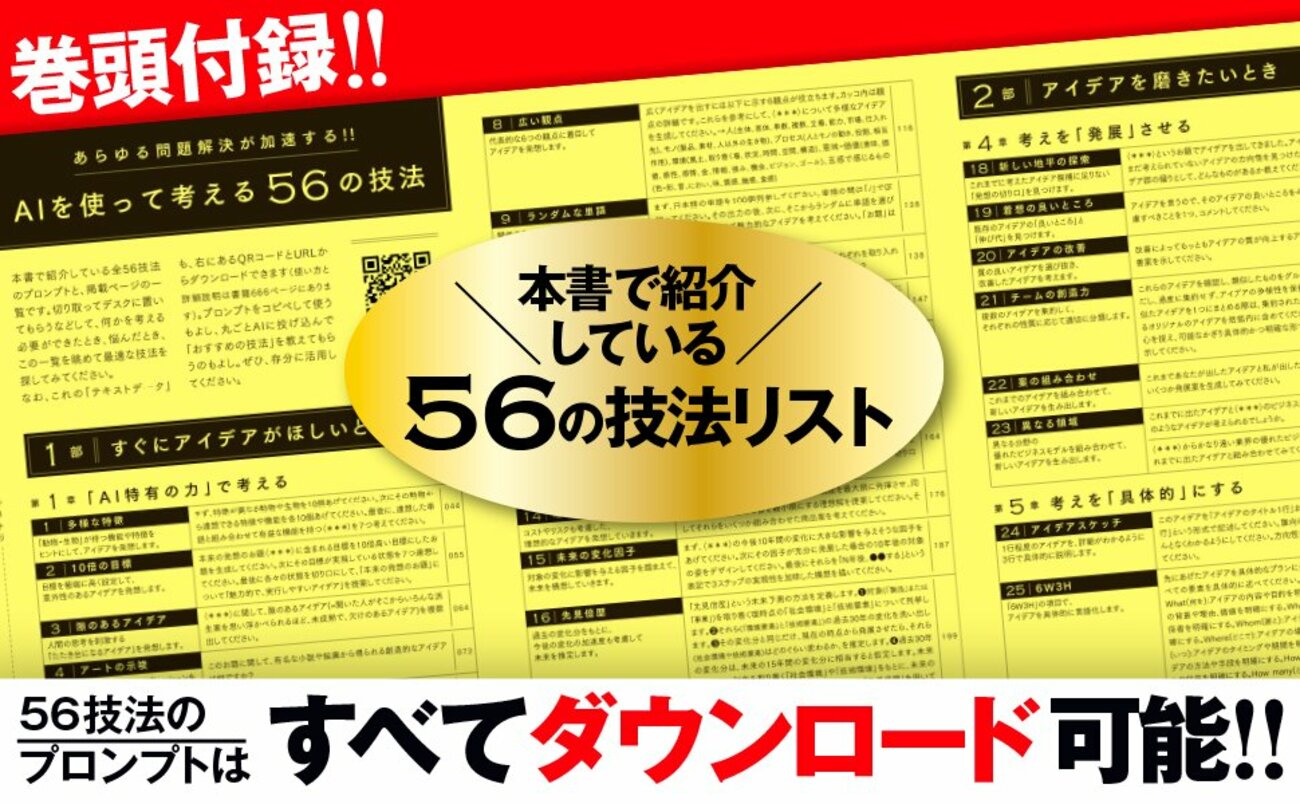

そう語るのは、グーグル、マイクロソフト、NTTドコモ、富士通、KDDIなどを含む600社以上、のべ2万人以上に思考・発想の研修をしてきた石井力重氏だ。そのノウハウをAIで誰でも実践できる方法をまとめた書籍『AIを使って考えるための全技術』が発売。全680ページ、2700円のいわゆる“鈍器本”ながら、「AIと、こうやって対話すればいいのか!」「値段の100倍の価値はある!」との声もあり話題になっている。思考・発想のベストセラー『考具』著者の加藤昌治氏も全面監修として協力し、「これを使えば誰でも“考える”ことの天才になれる」と太鼓判を押した同書から、AIの便利な使い方を紹介しよう。(構成/ダイヤモンド社・石井一穂)

Photo: Adobe Stock

Photo: Adobe Stock

AIを「頭の使う作業」に活用する

AIを雑談や効率化のためだけに使うのは少々もったいない。

AIは、「頭を使う作業」にもAIは活用できます。

ただし、適当な聞き方をしても、質の良い回答は得られません。

ロクでもない回答が返ってきてしまうときには、人間側の質問(プロンプト)が適切でないことがほとんどなのです。

たとえば、自身の思考の問題や障害を洗い出したいときにも、AIは活用できます。それが、『AIを使って考えるための全技術』で紹介されている技法その30「リスクの検証」です。

こちらが、そのプロンプトです。

〈アイデアを記入〉

提案された新規事業アイデアにはどのようなリスクが存在するか教えてください。

<技法「リスクの検証」の指示文(プロンプト)②>

〈リスクを記入〉というリスクをカバーする方法を考案して、アイデアをバージョンアップしてください。

※プロンプト①であがったリスクのなかで、とくに重要だと思うものを選んで②を使ってください

――『AIを使って考えるための全技術』(352ページ)より

思考の潜在リスクをAIで検証する

アイデアを本格的に磨く手法に「PPCO」があります。

Plus Potential → Concern → Overcomeの順で進めるブラッシュアップ法で、新事業や教育、地域課題など幅広く使われています。

まずアイデアの良い点や可能性を列挙し、次に懸念点を洗い出す。そのうえで重要な懸念を上位3つに絞り、克服策を考える。

創造性を保ったまま、実行可能な企画に仕上げるのがPPCOの狙いです。

ただしこの方法は、リスクの発見と優先順位付けが難しく、経験が浅い人には負荷が高い。

そこで使えるのが、AIでPPCOを実行する技法「リスクの検証」です。

AIにまずリスクを広く抽出させ、重要なものを人間が選ぶ。次に、そのリスクの対処とアイデア改善をAIに依頼する。人力なら数時間かかる作業を、短時間で進められます。

「社内評価制度のアイデア」を検証してみよう

では、この技法を実践してみましょう。

ここでは「社内評価制度の新しいアイデア」を例にして実践してみます。

たとえば、社員の働きぶりを「AI」を活用して公平に評価するといったアイデアがあったとします。

そこで、技法「リスクの検証」のプロンプトを使って、AIにこのように聞いてみます。

〈働き方の「可視化経営」:社員の出退勤時刻、会議での発言量、チャットの返信速度、業務の進捗、上司や同僚からの評価など、日々の行動データをAIが自動で収集・分析し、個人別・チーム別にスコア化して社内で共有するサービス。感覚や印象に頼らず、仕事の取り組み方や貢献度をデータとして把握できるようにすることで、評価やマネジメントの判断材料を揃えることを目的とする。〉

提案された新規事業アイデアにはどのようなリスクが存在するか教えてください。さて、AIはどのようなアイデアを出してくるのでしょうか。

このアイデアは「評価の属人性を減らす」「マネジメントの判断材料を揃える」という点で魅力がありますが、事業としては“効きそうだからこそ危ない”タイプのリスクがいくつも重なっています。主なリスクを、レイヤー別に整理します。

1. 評価の“正しさ”が保証できないリスク(本質リスク)

測れるもの=価値、になってしまう危険があります。

・返信が早い=貢献度が高い

・発言量が多い=生産的

・出社時間が長い=頑張っている

こうした代理指標(プロキシ)が、いつの間にか「評価そのもの」になると、

・深く考える人

・裏方で支える人

・火消し・調整役

が過小評価されやすくなります。

結果として、「本当に価値を生む行動ほど、スコアが伸びない」という逆選択が起きる可能性があります。

2. ゲーミフィケーション崩壊リスク(行動の歪み)

スコアが可視化・共有されると、人は最適化を始めます。

・会議で“中身のない発言”が増える

・既読・即レス文化が過剰に加速する

・難しい仕事より、スコアが伸びやすい仕事を選ぶ

つまり、

「成果を出すため」ではなく「スコアを上げるため」に働く状態が生まれやすい。これは短期的には活性化して見えても、中長期で生産性を下げる典型パターンです。

3. 心理的安全性の破壊リスク(組織文化リスク)

行動が常時スコア化・共有される環境は、

・失敗しにくい行動しか選ばない

・無難な意見しか言わない

・目立たない挑戦を避ける

という萎縮効果を生みます。

特に日本企業では、

・上司の評価

・同僚との比較

・空気を読む文化

が重なり、

「監視されている感覚」=モチベーション低下につながるリスクが高い。

4. データ倫理・プライバシー・法的リスク(致命傷になりうる)

この領域は一発アウトの可能性があります。

・労働時間・発言量・評価のスコア化は → 個人情報・センシティブ情報に該当する可能性

・AIによる評価・スコアリングは → 説明責任(なぜこの点数か)が問われる

・評価結果の社内共有 → パワハラ・差別・不利益取り扱いに直結しやすい

法的にグレーなだけでなく、炎上・不信・導入停止のリスクが常につきまといます。

5. 導入企業側の“責任転嫁”リスク(プロダクト側の罠)

企業はこう言い始めます。

「AIのスコアなので、うちの判断じゃありません」

すると、

・不当評価の矛先がプロダクトに向く

・紛争時の責任境界が曖昧になる

・ベンダーが“疑似人事部”化する

結果として、SaaSなのに、極めて重い人的・法的責任を背負うことになります。

6. 市場受容性リスク(売れない理由が“正しい”)

導入を決める経営層は興味を持ちやすい一方で、

・実際に使われる現場社員

・労組・人事・法務

からの反発が強い。

結果として、

・PoC止まり

・一部部署限定

・形骸化

という「売れたが、広がらない」SaaSになる可能性が高い。

まとめ

このアイデアの最大のリスクは、「測れるものを整えた結果、測れない価値を壊してしまう」点にあります。

もし事業化するなら、

・評価ではなく「自己内省用」

・スコアではなく「変化の可視化」

・共有ではなく「本人限定フィードバック」

など、“権力と結びつかない設計”に逃がせるかが、生死を分けるポイントです。

ふむふむ。もはやこのアイデアは穴だらけのように思えてきました。

ですが、ここで終わらないのがこの技法の特長です。

AIが挙げたリスクの中で、「これはとくにリスクが高そうだ」と思うものがあれば、「リスクの検証」のプロンプト②を使って、このように聞きます。

〈4. データ倫理・プライバシー・法的リスク(致命傷になりうる)

この領域は一発アウトの可能性があります。

・労働時間・発言量・評価のスコア化は → 個人情報・センシティブ情報に該当する可能性

・AIによる評価・スコアリングは → 説明責任(なぜこの点数か)が問われる

・評価結果の社内共有 → パワハラ・差別・不利益取り扱いに直結しやすい〉

というリスクをカバーする方法を考案して、アイデアをバージョンアップしてください。

さて、AIは自らが指摘したリスクを、どのようにカバーしてくるでしょうか。

ここは「守りの対策」を積み上げるというより、設計思想をひっくり返すことで一気にリスクを下げられます。

以下は、あなたが挙げた①個人情報性/②説明責任/③不利益取り扱いを同時にカバーしながら、アイデア自体を“進化させる”案です。

バージョンアップ案:「評価しない可視化経営」――判断権をAIに渡さない設計

1. 【根本転換】AIは「評価」しない。するのは“翻訳”だけ

まず最大の変更点です。

×:AIが「あなたは◯点」「貢献度が低い」

◯:AIは「あなたの行動データを、人間が理解しやすい言葉に翻訳する」だけに徹する

具体例

「会議発言量が少ない」 →「直近2週間、あなたは発言数は少なめですが、議事録に反映された決定事項への貢献率は高めです」

「返信が遅い」 →「即レスは少ない一方、返信後の修正依頼発生率は低めです」

・点数・序列・ランキングを廃止

・AIは“判断”せず、“材料の整理役”に限定

これで「説明責任」「AI差別」「不当評価」の多くが消えます。

2. 【個人情報対策】データの主語を「人」から「状態」に変える

before

Aさん:返信速度 早い/遅い

Bさん:会議発言量 少ない

after

「このチームは、非同期コミュニケーションが多い状態」

「このプロジェクトは、会議での合意形成に時間がかかる傾向」

これは個人データ → 状態データへの抽象化です。経営・マネジメント層が見るのはチーム傾向・プロジェクト傾向のみ。個人の詳細ログは本人だけが見られる“内省用ダッシュボード”に。これにより、社内共有=個人攻撃にならない。

3. 【説明責任】「点数」ではなく「因果の仮説」を提示する

AIスコアが危険なのは、「なぜそうなったのか」がブラックボックスになる点。

そこで出すのは点数ではなく、仮説文。

例

「最近、会議時間が長引いているのは『参加人数が増えた』『決裁者が途中参加している』可能性があります」

「チャットの滞留が増えた要因として『業務の前提条件が曖昧』『確認事項が多段階化』が考えられます」

・必ず「可能性」「仮説」表現に限定

・AIは“断定しない”設計

これにより、「AIがそう言ってるから」という責任転嫁を防ぐ。

4. 【不利益回避】評価・処遇に“使えない”ことを契約で縛る

ここはビジネス的にも重要です。

利用規約・導入契約で明示:「本サービスのデータは評価・査定・降格・解雇判断に利用不可。使えるのは1on1、チーム改善、業務設計見直しのみ。」

これは一見、売りにくく見えますが、実際は「評価に使えないから、導入しやすい」という逆転が起きやすい。

5. 【社内共有の再設計】共有するのは「良い変化」だけ

全社共有:

「この部署では会議時間が20%短縮した」

「このチームは非同期化が進んだ」

非共有:

・個人比較

・下位表示

・ネガティブランキング

比較対象は「他人」ではなく「過去の自分/過去のチーム」

進化後のアイデア定義(書き直し)

社員の行動ログをAIが自動収集・整理し、個人には“振り返り用の可視化”を、組織には“状態把握のための傾向データ”を提供するサービス。

AIは評価や点数化を行わず、行動の変化や業務構造の特徴を仮説として提示する。

感覚や印象に頼らない対話・改善の材料を整えることで、マネジメントの質と心理的安全性の両立を目指す。

いいですね。

「AIに評価させない」という割り切りが、倫理・法務・現場の三方良しを一気に成立させています。

スコア化の誘惑を断ち、可視化を“対話の材料”に限定した設計は、導入障壁を下げつつ長期運用にも耐えそうです。実務を知っている人が考えたような、かなり現実的な進化案だと感じました。

自分の思考やアイデアをさらに磨きたいとき、ぜひ技法「リスクの検証」を活用してみてください。

(本稿は、書籍『AIを使って考えるための全技術』掲載の技法をもとに作成したオリジナル記事です。他にも書籍では、AIを使って思考の質を高める56の方法を紹介しています)