実際のデモでは、かなり複雑な要求が含まれた旅行プランの依頼(妻と8歳と12歳の子供と一緒にロンドンに旅をしたいが、グループシートが取れる安価な直行便のチケットと、SUVのレンタカー、そしてWi-Fiのあるホテルの予約を頼む)に対しても的確な回答を返し、その場で予約を入れられることをアピールした。

さらに、プリセットされたサービスに希望のものがない場合でも、rabbitティーチモードという機能を使うと、ユーザーが操作の手本を行って学ばせるだけで、rabbitOSがやり方を覚え、r1から声で操作可能となる。

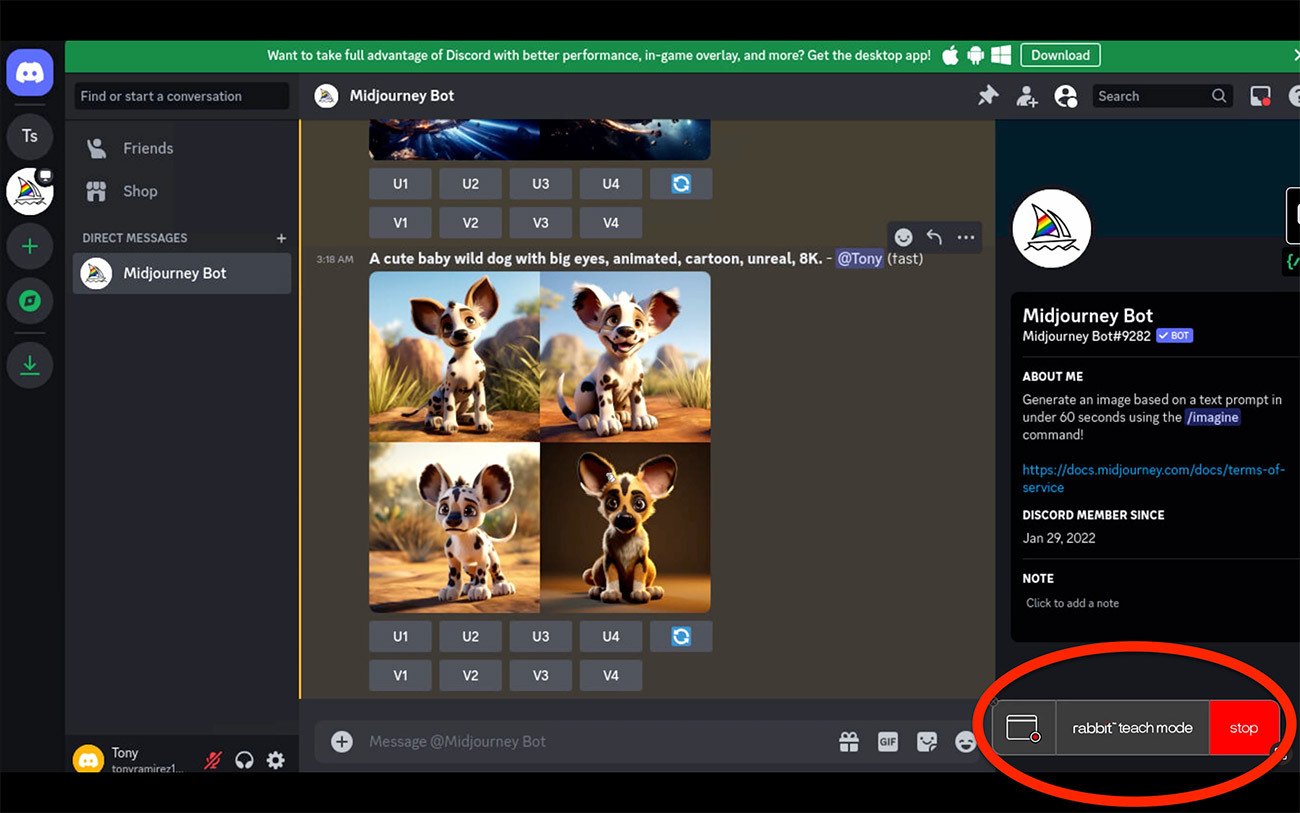

SpotifyやApple Musicなど、主要なWebサービスとの連携機能はプリセットされているが、コンピューター上で「ティーチモード」を使い、必要なアプリの操作方法を学ばせれば、もっと複雑な処理もできるようになり、r1から話しかけるだけで利用可能になる。写真は、画像生成AI・Midjourneyの使い方を、ティーチモードでr1に教えているところ Photo:rabbit 拡大画像表示

SpotifyやApple Musicなど、主要なWebサービスとの連携機能はプリセットされているが、コンピューター上で「ティーチモード」を使い、必要なアプリの操作方法を学ばせれば、もっと複雑な処理もできるようになり、r1から話しかけるだけで利用可能になる。写真は、画像生成AI・Midjourneyの使い方を、ティーチモードでr1に教えているところ Photo:rabbit 拡大画像表示

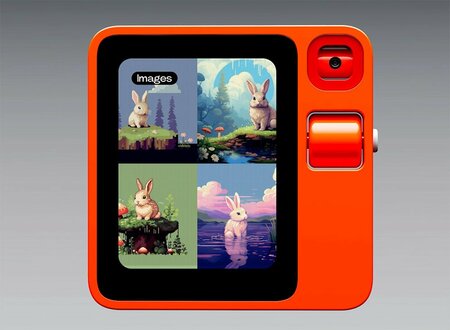

Midjourneyの使い方を学ばせた後で、r1に画像生成(この場合には、ウサギのイメージ)を依頼し、実際にAIがMidjourneyを操作して得られた結果を表示させている Photo:rabbit

Midjourneyの使い方を学ばせた後で、r1に画像生成(この場合には、ウサギのイメージ)を依頼し、実際にAIがMidjourneyを操作して得られた結果を表示させている Photo:rabbit

こうした処理を実現しているのが、大規模言語モデル(LLM)ならぬ「大規模アクションモデル」(LAM)だ。Rabbitの独自発想であるLAMは、既存のアプリの構造と、それを使うユーザーのアクションを学び、再現するための仕組みであり、これによって、理論上、従来のLLMやAIエージェントでは不可能だった、すべてのアプリやWebサービスのAIによる操作が可能になると説明されている。