「有害な動画」でAIを教育するとどうなる?

まず、イヤッドたちは、ソーシャル・メディア上で見つけた好感の持てる無害な動画(たとえば、海岸や花、鳥、ケーキなどを映した動画)を供給してアルゴリズムを教育した。

さらにその後、まったく同じコードを持つ同じアルゴリズムを、ソーシャル・メディア上で見つけた不快で有害な動画(死や暴力に関わる動画)を供給して教育した(動画には、暴力行為が含まれていることを知らせるキャプションがつけられた。ただ、倫理的な配慮から、アルゴリズムの教育は、動画につけるキャプションについて行なわれ、動画そのものについては行なわれなかった)。

それぞれ違った動画で教育をしたアルゴリズムに、その後、「ロールシャッハ・テスト」を受けさせた。インクの染みを見せて、何に見えるかを答えさせるという有名な性格検査である(見ようとすればいろいろなものに見える絵を見た時に、潜在意識に何が現れるかを知るのが目的の検査だ)。

偏った学習データで教育された「猟奇的なAI」

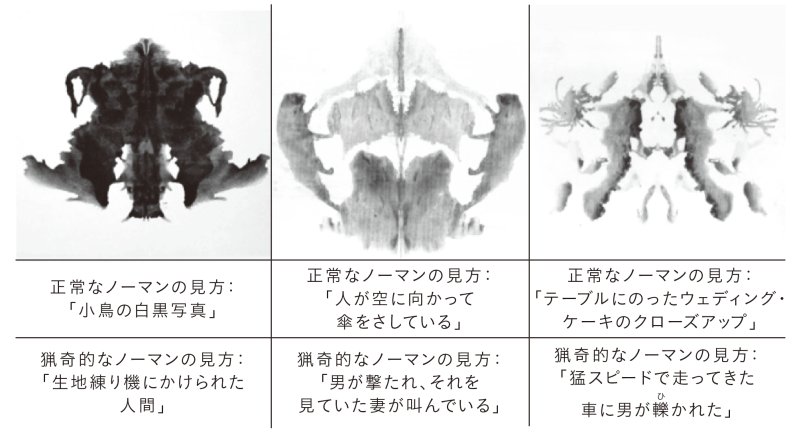

無害な動画ばかりを見た「正常」な「ノーマン」と、有害な動画ばかりを見た「猟奇的」な「ノーマン」は、同じインクの染みに対してまったく異なる反応をした。

正常なノーマンが、インクの染みはケーキや鳥、傘などに見えると答えたのに対し、猟奇的なノーマンは、射殺された人間や、猛スピードで走る車にはねられた人などに見えると答えた([図3─9]を参照)。

[図3-9]MITのAI「ノーマン」の実験結果。「正常」なノーマンと、「猟奇的」なノーマンに同じロールシャッハ・テストを受けさせた。図は2つのノーマンが同じ絵につけたキャプションの例。「正常」なノーマンは、ソーシャル・メディアに投稿された無害で平和な動画で教育した。「猟奇的」なノーマンは、暴力や死に関わる動画ばかり見せて教育した。AIのコード自体はどちらも同じである。

[図3-9]MITのAI「ノーマン」の実験結果。「正常」なノーマンと、「猟奇的」なノーマンに同じロールシャッハ・テストを受けさせた。図は2つのノーマンが同じ絵につけたキャプションの例。「正常」なノーマンは、ソーシャル・メディアに投稿された無害で平和な動画で教育した。「猟奇的」なノーマンは、暴力や死に関わる動画ばかり見せて教育した。AIのコード自体はどちらも同じである。

どちらのノーマンもコードはまったく同じで、見せたインクの染みも同じものである。違うのは、教育のさいに供給した動画である──一方のノーマンには暴力的な動画ばかりを供給し、もう一方には、平和な動画ばかりを供給した。

つまり、前者はソーシャル・メディアに暴力的な動画ばかりが投稿される世界を見せ、後者には平和で日常的な動画ばかりが投稿される世界を見せたわけだ。

人間がAIに及ぼす影響

このことからわかるのは、ハイプ・マシンは、私たちの行動いかんで大きく変化するということだ。

私たちが死と暴力に関わる投稿ばかりしていれば、アルゴリズムは何もかもを死や暴力に結びつけるようになる。ほかに結びつけられるものがないからだ。

平和で楽しい無害な投稿ばかりしていれば、アルゴリズムは何を見ても平和で無害な解釈をするようになるだろう。