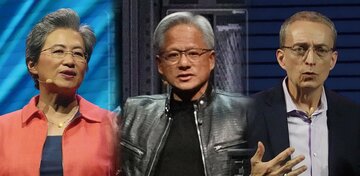

写真提供:NVIDIA

写真提供:NVIDIA

生成AI(人工知能)ブームの中で、売り上げ規模と時価総額で世界のトップに立った米エヌビディアの快進撃はまだ始まったばかりだ。アマゾン・ドット・コムやグーグルなど米国のビッグテックの生成AIへの投資意欲は強気の姿勢が続き、エヌビディアのGPU(画像処理半導体)の圧倒的な需要が続くことは間違いない。特集『半導体の覇者』#6では新型GPU「ブラックウェル」の市場投入の本格化で浮き彫りになるエヌビディアの強さとリスクに迫る。(ダイヤモンド編集部 村井令二)

エヌビディアのGPUの需要は増え続ける!

ジェンスン・フアン氏が示す規模拡大の原則

「AI(人工知能)に必要な計算資源は『スケーリング則』に従って途方もない量で増え続けている。毎年AIモデルサイズは2倍、データ量が2倍、つまり4倍の計算量が必要になっているということだ」

エヌビディアのジェンスン・フアン最高経営責任者(CEO)は11月13日、東京都内で開いた「NVIDIA AI Summit Japan」で、生成AIの能力向上によって同社製GPU(画像処理半導体)の需要が1年ごとに増大していくとの見方を示した。

生成AIは、モデル数と学習データを増やせば増やすほど性能が向上する。これが半導体業界で「スケーリング則」と呼ばれる法則だ。これに従えばGPUの物量を投入すればするほど生成AIは「賢く」なるため、年間4倍のペースでGPUの需要は拡大していくとの見方である。半導体集積回路の性能が2年ごとに倍増するという「ムーアの法則」を超える成長を見込んでいるという自信の表れに他ならない。

実際に生成ブームを作った米オープンAIは2022年11月にChat GPTを公開して以来、GPT3.5からGPT4へと大規模言語モデル(LLM)を段階的に改良して性能を劇的に向上させてきた。これに対抗するためグーグルを含む他の企業も新しいLLMモデルの開発競争を激化させている。

LLMの学習データが劇的に増えるため、各陣営がエヌビディアのGPUをいかに大量に調達するかが勝負を分けることになる。これに加えて最近は別の動きが出てきた。

今年9月、オープンAIはLLMの最新モデル「オープンAI-o1(オーワン)」を公開した。これは、数学や化学やプログラミングなどの複雑な問題に対して論理的な答えを導き出す“推論性能”を強化した新しいタイプのLLMだ。つまり従来は、GPUを大量に必要とするのはLLMの学習部分だとされてきたが、推論においても複雑な思考を駆使するため大量のGPUが必要になってきているという現象である。

フアン氏は「学習と推論の二つのスケーリング則によって、われわれは驚異的なスピードで計算能力の向上を推進していかなければならない」と語る。つまり、これほどまで爆発的に計算資源の需要が拡大すれば、もはや従来型のGPUの量を増やすだけでは需要に追い付かないということだ。

そこでエヌビディアはGPUの新製品を「1年サイクルで投入する」(フアン氏)戦略を進める。その第1弾が24年3月に公表した新型GPU「ブラックウェルB200」だ。同年11月~25年1月に出荷を開始し、25年に本格的に出荷する。

すでに「フル生産に入った」(フアン氏)新製品は、GPUの価格を押し上げてエヌビディアの快進撃をさらに見せつけることになるのだろうか。次ページでは、そのチャンスとリスクに迫る。