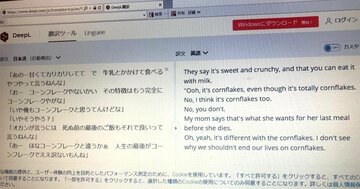

永田 ええ。08年頃の統計翻訳でも欧米語間のマニュアルなどの翻訳は十分使えるものだったので、日本の感覚とは違っていたでしょう。日本の翻訳者たちは08年時点では到底機械翻訳は使えないという意見でしたが、16年に初めて使えるという意識になったと思います。さらに一段階レベルが上がったのが18年くらいで、翻訳が難しかった中英間の翻訳も「ヒューマン・パリティ(human parity、人間並み)」と主張する人が現れました。

秋山 人間と同じだと。

欧米語同士はすでに人間並みの

ヒューマン・パリティを達成

永田 しかし、研究者は中国語・英語間の翻訳に関しては(当然日本語と英語も)そうではないという見解でした。というのは、一文ずつ文を入れて訳して相手に見せて会話するようなスマートフォンの翻訳機と同じで、文をひとつだけ入れて翻訳するとそれなりに正しく、そのあたりの高校生よりはよほどできますし、自分で翻訳したものと比べて参考にして、自分の英訳をよりよく修正するような使い方はできる。しかし、会議のような場で、文脈や状況も含めて翻訳させるとか、まとまった文章を入れると、文章同士の前後関係や文脈を考慮した上で訳を変えるようなことはしないので、一文一文は意味を成すものの、全体としては意味のわからない文章になってしまうからです。ヒューマン・パリティは遠い、ただ、十分人間の役には立ちます。

あきやま・すすむ/プリンシプル・コンサルティング・グループ株式会社 代表取締役。リクルート入社後、事業企画に携わる。独立後、経営・組織コンサルタントとして、各種業界のトップ企業からベンチャー企業、外資、財団法人など様々な団体のCEO補佐、事業構造改革、経営理念の策定などの業務に従事。現在は、経営リスク診断をベースに、組織設計、事業継続計画、コンプライアンス、サーベイ開発、エグゼクティブコーチング、人材育成などを提供するプリンシプル・コンサルティング・グループの代表を務める。京都大学卒。国際大学GLOCOM客員研究員。麹町アカデミア学頭。今回の対談相手の永田昌明氏は同じ高校の出身で、家も近所で勉強を教えてもらうなど、とても優しく接してくれた敬愛する先輩。

あきやま・すすむ/プリンシプル・コンサルティング・グループ株式会社 代表取締役。リクルート入社後、事業企画に携わる。独立後、経営・組織コンサルタントとして、各種業界のトップ企業からベンチャー企業、外資、財団法人など様々な団体のCEO補佐、事業構造改革、経営理念の策定などの業務に従事。現在は、経営リスク診断をベースに、組織設計、事業継続計画、コンプライアンス、サーベイ開発、エグゼクティブコーチング、人材育成などを提供するプリンシプル・コンサルティング・グループの代表を務める。京都大学卒。国際大学GLOCOM客員研究員。麹町アカデミア学頭。今回の対談相手の永田昌明氏は同じ高校の出身で、家も近所で勉強を教えてもらうなど、とても優しく接してくれた敬愛する先輩。

秋山 欧米の言葉同士であれば今でもすでにヒューマン・パリティですか。

永田 一文ずつの翻訳ならば、そうですね。ただ、ニューラルネットワークは言語でなければ、すでに人間を超えているものもあります。たとえば画像認識。遠くから見て誰かを当てるような監視機能は機械が人間を超えているので、研究者によってはヒューマン・パリティくらいでは驚かないんですよ。言語は遅れていたのでヒューマン・パリティでも十分驚きがありますが(笑)。

秋山 人間って、状況に応じて幅広い話し方をしますよね。言うことが明確である場合もあるし、含みを持ってしゃべる場合もある。

永田 ポケトークのようなスマートフォンの翻訳機は場を共有しているのが前提で、これが買いたいなど、伝えたい意思がはっきりしているときに使えば、今の自動翻訳で十分です。

秋山 ところで、統計翻訳にしてもニューラルネットワークにしても、日英の対訳データ(コーパス)には何を使っていたのですか。

永田 特許のテキストです。少しさかのぼると、機械的統計翻訳の最初、IBMはカナダの国会議事録を使っていました。カナダは英語とフランス語が公用語で、公文書は必ず英仏両語で残さなければならず、大量のデータがありました。しかし、日英対訳に関しては、少なくとも90年代に日本政府はそんなに大量の対訳データを持っていませんでした。対訳が公的に存在するのは特許でした。企業が商品をいろいろな国で売りたい、それには製品の技術に関する特許を日本にも中国にもヨーロッパにもアメリカにも出願しなければならない。優先権出願というしくみがあり、よその国で出願した特許は日本で出した特許の何番に相当するというデータが全部管理されているのです。EUがEPO(欧州特許庁)のデータベースを売っていて、どの特許とどの特許が対応しているかがわかるので、優秀な対訳データになります。対訳部分を探して、何百万文の対訳データを作りました。

秋山 ただ、当然内容は工学、科学技術偏重になりますよね。

永田 そうですね。最初の頃は。NTTでも今はウェブのデータを集めてやっています。Googleは自社にサーチエンジンがあるので、クローラー(検索ロボット)を走らせて世界中のウェブページを集めてきてその中で対訳データを探して、翻訳サービスを提供しています。長年Google以外の他社は、ウェブを周回して対訳データを集めることが技術的に難しかったのですが、5~6年前にEUが多額の資金を投じて、ウェブから、ヨーロッパ言語間の対訳の文章を集めるParaCrawlというプロジェクトを進めました。EUは加盟国のすべての言語を公用語として公文書を翻訳しなければならないという義務があるので、翻訳は重大事だったからです。たとえば、ドイツ語英語対訳は3億文くらい集まっています。そのソフトが公開されているので、NTTも2年前にこれを真似して、日英対訳のデータ1000万文を集めてJParaCrawlという名前で公開しました。

秋山 これが使えればかなりの状況をカバーできるので、翻訳のレベルは上がるでしょうね。

さて、ここから、ニューラルネットワーク(ディープラーニング)の画期的な技術革新について詳しくお聞きしたいのですが、ニューラルネットとディープラーニングは違うのですか。

永田 ニューラルネットワークの中で進んだものがディープラーニングです。先ほどお話ししたように、ディープラーニングは画像認識でまず始まりました。たとえば飛行機やネコの画像を他から分類する。ネットワークを50層、100層と積んでいくと、精度が高くなり、これをディープラーニングといっています。

秋山 人間の認識も階層になっていますよね。生物>ネコ科>トラとか。AIにもそういう階層があるのですか。

永田 画像認識はありますね。人間の網膜と同様に受容野という用語で表現します。一番下の階層では、3画素×3画素の領域しか見ず、出力を次の段の階層につないでいくにつれて、だんだん広い範囲を見るようになります。低い階層では、点が白なのか黒なのかを見て、ちょっと階層が上がると線の方向、もっと上がると丸みがあるとか、角があるとかを見て、さらに上はネコそのものの輪郭を捉える。

秋山 階層が上がればより高い精度の情報を捉えるようになるのですね。言語はどうですか。

永田 単語を一個一個ニューラルネットに入れていって、内容を更新していきます。普通のニューラルネットには、入力と出力があって、入力した信号を拾い、それがある閾値(反応させるのに必要な最小の刺激)を超えたら出力して上につないでいきます。これを順伝播といいます。

秋山 入力し、ある条件を満たせば、出力されて上の階層に行くのですね。