声だけでなく、顔の表情からも感情を察知

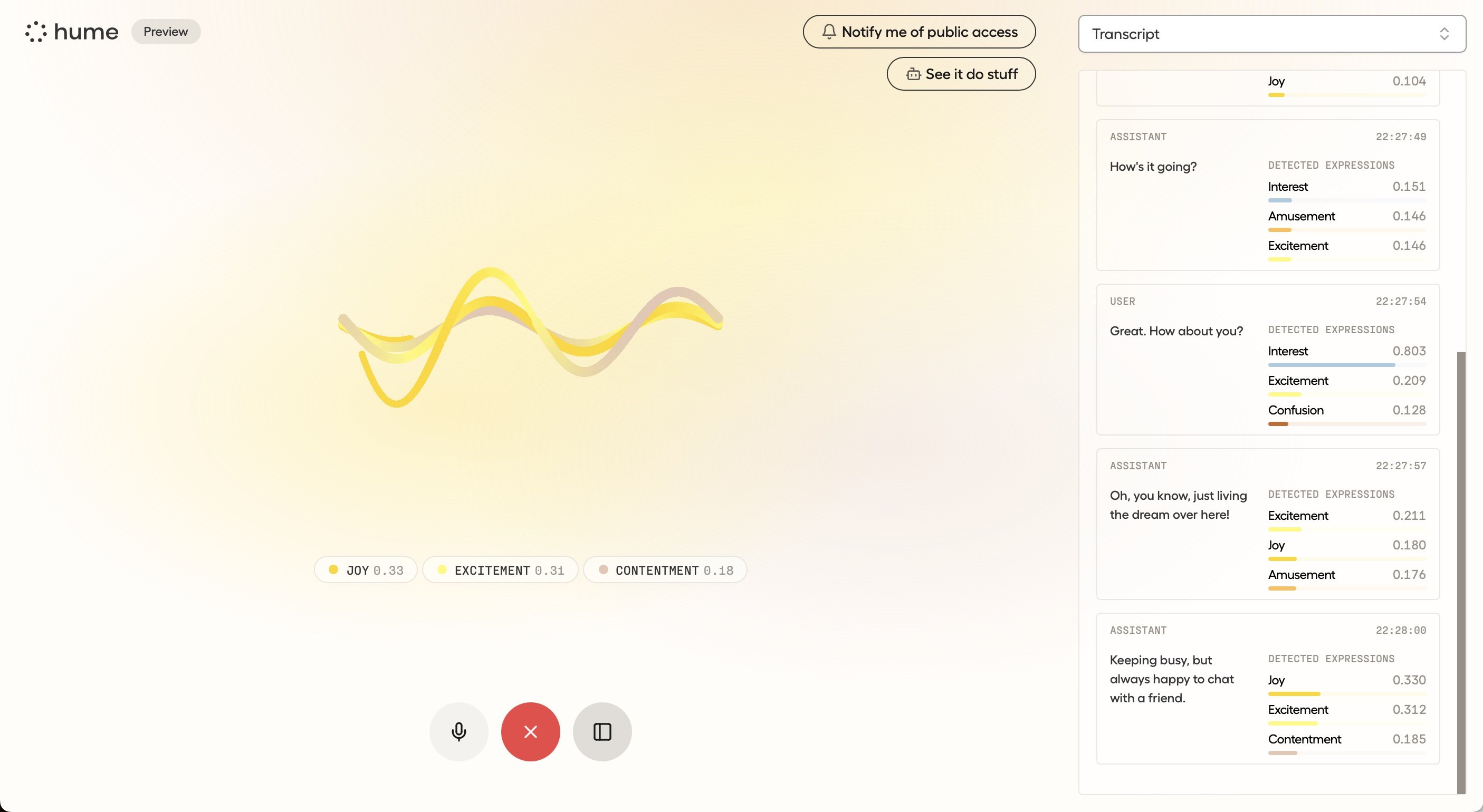

感情を判断するためのインターフェースとなっているボイスチャット機能も非常に高いレベルにある。実際に公開されている英語のデモチャットで、わざと声のトーンを変えながら試してみると、AI側の応答も発話の内容はもちろん、口調自体が本当に心配したり、元気づけてくれたりするよう変化するので、このスムーズな会話を一方的に打ち切ってしまっても良いものかと躊躇(ちゅうちょ)してしまうほどだ。

ボイスチャット中に、AIとユーザーのそれぞれの声に込められた感情がリアルタイムで数値化されて表示される。実際の企業のコールセンターなどで運用する場合は、これらの数値を内部的に利用して、応対の仕方を変えていくといった利用法が考えられる 拡大画像表示

ボイスチャット中に、AIとユーザーのそれぞれの声に込められた感情がリアルタイムで数値化されて表示される。実際の企業のコールセンターなどで運用する場合は、これらの数値を内部的に利用して、応対の仕方を変えていくといった利用法が考えられる 拡大画像表示

これ単体でも、コールセンターなどにおける顧客対応の自動応答に革命をもたらす可能性があるが、Humeのもう一つの柱である表情解析の技術と組み合わせることで、言葉になっていない感情の起伏なども認識できるようになる。もちろん、運用にあたってはプライバシーへの配慮が欠かせないが、たとえば商品テストなどの被験者からの評価をより的確なものとするために、同意を得て使用するようなユースケースなどが考えられそうだ。

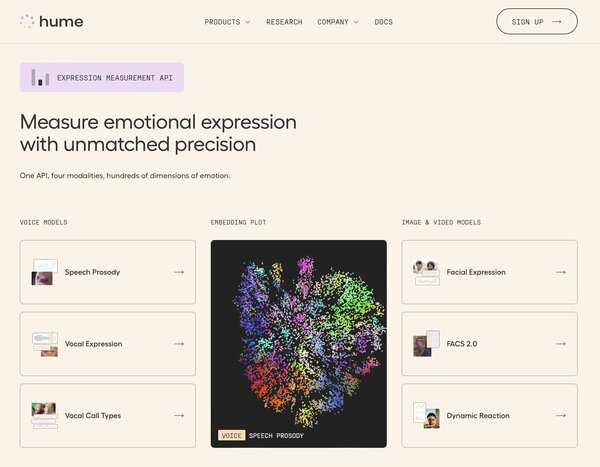

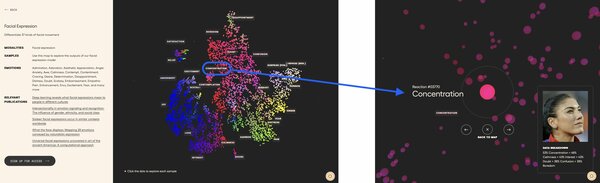

Humeは、声の分析に加えて、表情のAI解析にも力を入れている。これは、それらの分析結果に基づいて作られた感情のクラウドともいえる3Dマップである 拡大画像表示

Humeは、声の分析に加えて、表情のAI解析にも力を入れている。これは、それらの分析結果に基づいて作られた感情のクラウドともいえる3Dマップである 拡大画像表示

Facial Expressionを選択して3Dマップ内の感情ワードをクリックすると、個々の表情からうかがえる感情の割合がパーセンテージで表示される 拡大画像表示

Facial Expressionを選択して3Dマップ内の感情ワードをクリックすると、個々の表情からうかがえる感情の割合がパーセンテージで表示される 拡大画像表示