同じ研究課題に対して数多くの「p値」を計算してはいけない

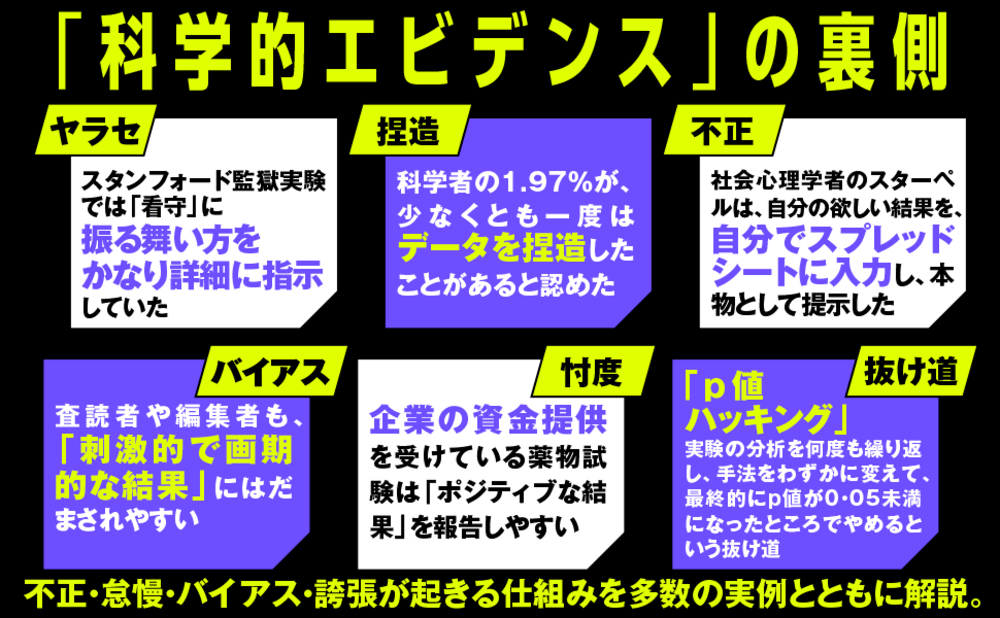

いずれのp値ハッキングも同じ間違いの例であり、皮肉なことに、p値がそれを回避するために発明されたもの、すなわちランダムな偶然性を利用している。

p値はノイズとシグナルを区別しやすくするために設計されているが、同じ研究課題に対して数多くのp値を計算すると、この能力は失われる。データや統計的検定に何らかの調整を加えるたびに、サイコロをもう1回振っているようなもので、ランダムな変動を拾って「本物」と判断する確率が高くなるのだ。

先ほど見たように、p<0・05の閾値は、仮説が間違っていた(たとえば、新薬が実際には効かない)場合に5%の確率で偽陽性の結果が出るという意味である。ただし、この5%という値は、1回の検定に対するものだ。簡単な計算をすればわかるように、仮説が間違っている世界では、統計的な検定の数を増やすと偽陽性の結果が出る可能性は雪だるま式に高くなる。

(関連性のない)5つの検定をおこなった場合に少なくとも1つの偽陽性が発生する可能性が23%なら、20の検定をすれば64%になる。このように何回も検定をおこなうと、フィッシャーが提案した5%の許容範囲をはるかに超える。そのときp値は、シグナルを見分ける助けになるどころか、ノイズの海に沈み始める。

(本稿は、『Science Fictions あなたが知らない科学の真実』の一部を抜粋・編集したものです)