言い換えれば、論文を読むという行為は、膨大な経験や試行錯誤の「結果」だけを学習することです。

これは、小学校の教科書でも同じことです。

教科書で日本地図を学習するにしても、その地図を描くために誰かが膨大な経験をしています。

しかし、日本地図を学ぶ小学生が、それに付随する膨大な経験まで学習する機会はおそらくないでしょう。

実は、AIの世界でも、あるAIに膨大な経験をさせて、ほかのAIがその結果だけを利用して学習するケースがあります。

これを、「AIの蒸留(distillation)」と呼びます。

「AIの蒸留」で、

スマホでもAIに学習させられる?

第4回、第5回連載で、AIのディープラーニングについて解説しましたが、ディープラーニングの場合、人間の脳を模したニューラルネットワークという技術でAIは自己学習をします。

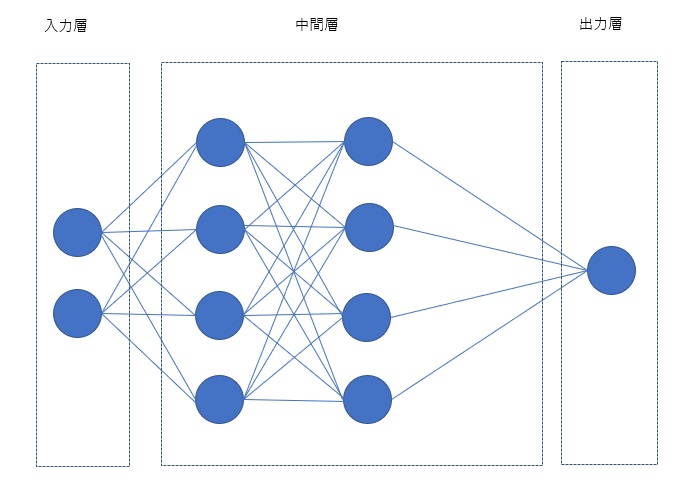

ここでは詳細に解説しませんが、次の図のようなニューラルネットワークにデータを入力し、中間層でさまざまな計算を行い、最終的に結論を導き出します。

「AIの蒸留」とは、簡単に言ってしまえば、この出力されたデータで、別のAIに再学習をさせることです。

先の論文のケースでは、膨大な学習を行うのは学者ですが、論文を読むことで、その結論を学生が再学習するイメージですね。

本来は、AIのディープラーニングには高速なプロセッサを搭載したスーパーコンピュータのようなハードが必要になります。

しかし、「AIの蒸留」ならば、それよりもはるかに機能が劣るプロセッサや、メモリ領域が少ないハードで、さらにニューラルネットワークの階層の数を少なくしても、AIはディープラーニングをすることが可能になります。

極論を言えば、スーパーコンピュータでなければできないような学習を、スマホに搭載されたAIでも再学習できてしまうというイメージです。