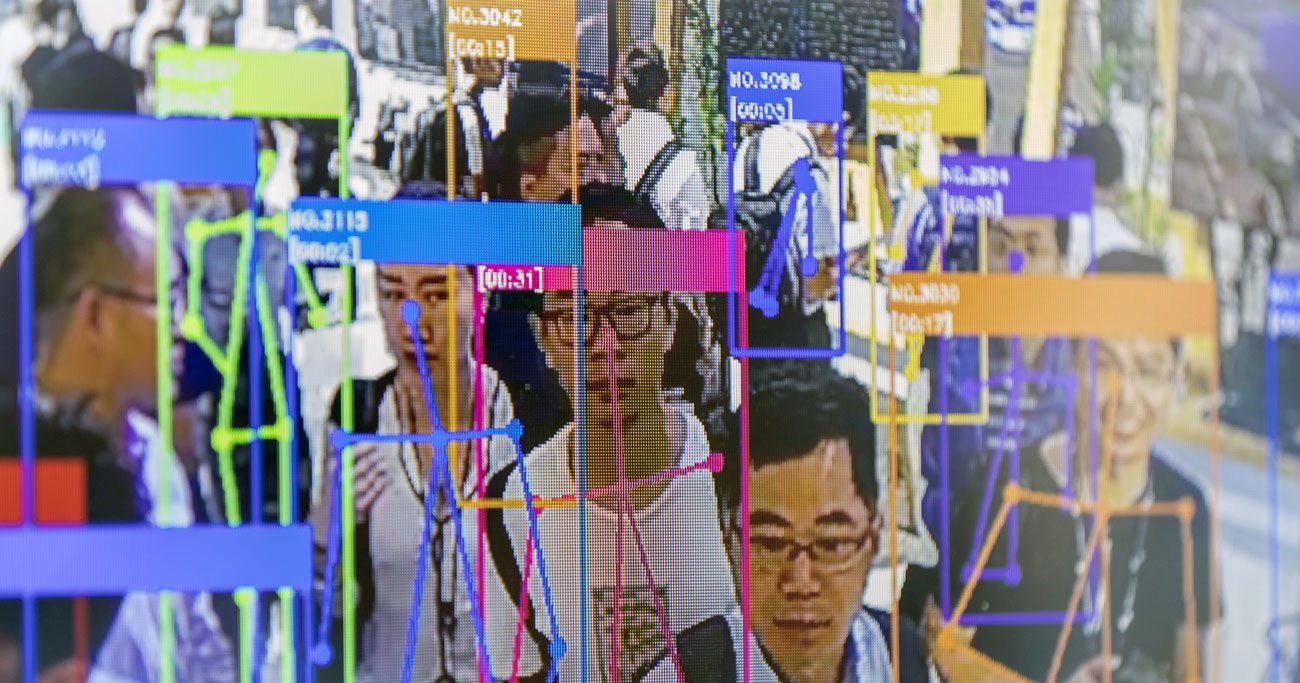

世界人工知能大会(WAIC)においてスクリーンに映し出された、顔認識AIのデモンストレーション(2019年8月、中国・上海) Photo:Bloomberg/gettyimages

世界人工知能大会(WAIC)においてスクリーンに映し出された、顔認識AIのデモンストレーション(2019年8月、中国・上海) Photo:Bloomberg/gettyimages

コロナショックを経て、人々が企業を見る目や意識、姿勢が大きく変化し、これまでよりもさらに誠実であることを求めている。また企業が、悪意はなくても勉強不足や想像力の欠如によって人権を侵害し、大炎上するケースも増えている。何に気をつけるべきなのか。本連載では、注目を集める企業の人権違反とその対応策について紹介する。連載4回目で取り上げるのは、テクノロジー企業で開発が進むAIについて。AIの学習に偏ったデータを与えていれば、AIもその思考法を学んで差別的な判断を下しやすくなる。またUNESCO(国際連合教育科学文化機関)は多くのAIアシスタントで女性の声が初期設定とされていることに警鐘を鳴らした。AI開発に必要な企業倫理について探った。

アマゾンの人事AIは“女性嫌い”?

「君は不採用だ」と人事AIが下すワケ

米アマゾン・ドット・コムのAI(人工知能)は“女性嫌い”――。そんな報道が、ロイターから発信されたのは2018年10月のことだった。

記事によると、アマゾンはAIを用いた人材採用ツールの開発を進めていたが、当該AIが“女性嫌い”であることが判明し、開発は中止されたという。AIによる履歴書の自動審査システムを構築すべく、アマゾンは過去10年間に同社が受け取った履歴書をAIにインプットして学習させたが、これが誤りだった。

ソフトウエア開発などの技術職では、過去の応募者および採用者の大部分が男性だったため、AIは「女性よりも男性の方が適している」と判断するようになったのだ。その結果、「女性」「女子大」などの言葉が履歴書に含まれていると、自動的に評価を下げるようになってしまったという。

このような「AIによる差別」は今後も容易に起こるだろう。

AIが知能を発揮するには、まず事前に学習用のデータを大量にインプットする必要がある。そのデータに偏りがあれば、当然ながらアウトプットにもバイアスがかかる。統計的に正しいデータさえ用いればいい、というわけではないのだ。

統計データには性差別・人種差別など、社会に現存する差別構造がそのまま反映されていることがほとんど。そのデータをベースに学習したAIも、差別的な判断を下すようになってしまう。

この観点でまさに今、国際的に問題視されているのが「顔認識AI」の技術だ。