余談になるが、思い出すのは、筆者がFacebook(当時)のAI研究者の取材中に聞いた、「グーグルが支払う年間の電気料金は、同社の全社員の年俸よりも多い」という話である。グーグルに限らず、AIチャットボットの急速な普及は、そうした費用をさらに押し上げるとともに、サーバーが発する熱も増大させているはずだが、その点を追及するメディアはほとんど見かけない。

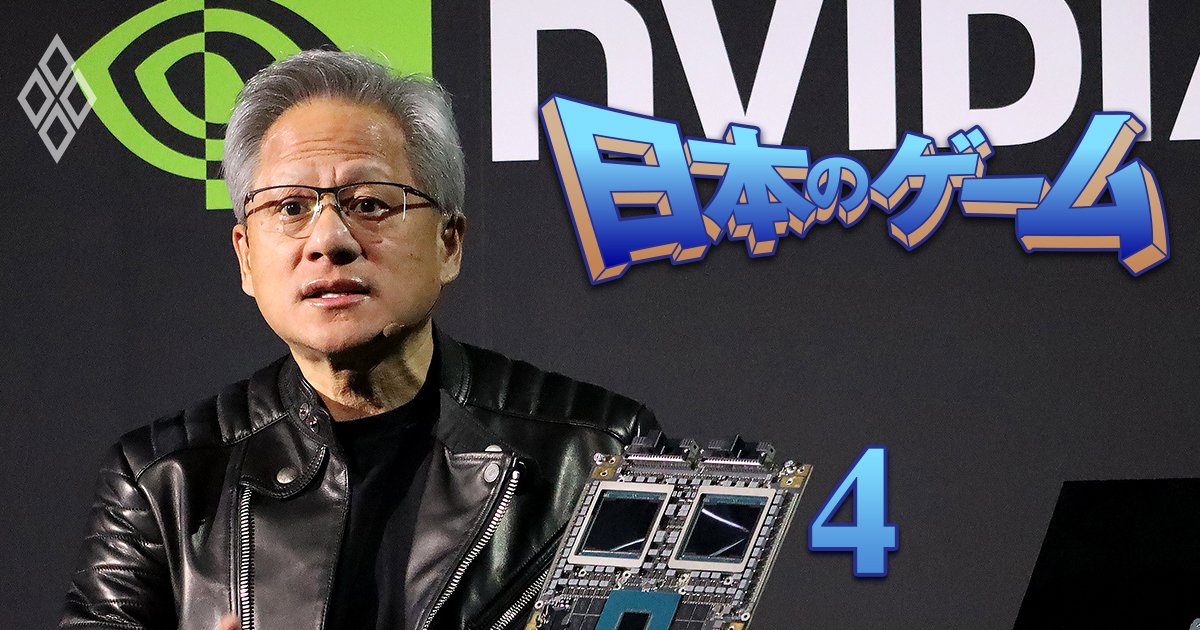

ChatGPT自身に、AIと電力消費の問題について説明させてみた Fig by K.O. 拡大画像表示

ChatGPT自身に、AIと電力消費の問題について説明させてみた Fig by K.O. 拡大画像表示

もちろん、さまざまな産業でAIが活用されることで、トータルな電力消費やCO2排出量を抑えられる効果も期待できるものの、現時点では増える一方であろう。メタのAI研究者たちはLLaMAの開発に当たり、そうした環境への影響を意識した……のかもしれない。

AIに警鐘を鳴らす識者もいるが……

どんどん賢くなっているAIチャットボットだが、AIが生成するアウトプットはある意味インターネットと同じく“ベストエフォート型”で、「正しい情報の提供に努めるが、内容の正確さの保証はない」という姿勢である。そうした技術が一般向けに競って公開されることへの批判もある。

最も顕著な例として、国立情報学研究所 社会共有知研究センター長の新井紀子氏は、インタビューの中で、「この魅力的だが未熟な技術が、社会にもたらすコストとリスクを背負う覚悟があるか」を問うている。現状のAIが「言語」を「記号」として認識しているだけで「意味の正しさ」を理解できないため、出力された情報が科学的に100%正しくなることはないこと。およびAIの誤りがなぜ、どのようにして起こったのかを人間が把握することが難しく、修正も極めて困難だからだ。

同様に、米国のセキュリティー専門家、ブルース・シュナイアー氏も「(パブリックコメントやSNSへのポストを大量に捏造できる)チャットGPTが民主主義をハイジャックする」可能性を指摘し、「現代言語学の父」と呼ばれるノーム・チョムスキー氏も「知性が欠落している」ChatGPTは「凡庸な悪」であり、盗用と無関心と疎外化を招くと主張している。

現在のAIにこうした不備があることは確かで、このような批判を否定することはできない。しかし人間の判断や行動が常に正しいわけでもない。問題は、AIがそうした情報を短時間のうちに大量に、かつ、自動的に生成できる点を悪用する人間がいるという点だ。

こうしたAIのネガティブ面を排除するためにはAI倫理の確立が求められる。コンプライアンス意識の高い企業や政府は、そうした規範やルール作りに動き始めているが、そうではない組織や国が存在する限りは、危険や不安は消えないだろう。

なお、画像生成AIの世界では、Adobeが独自のAIと自社のAdobe Stock内の学習許可済みの画像による学習を組み合わせ、元画像のクリエイターの権利にも配慮した「Firefly」というサービスのベータ運用を開始している。生成された情報を安心・安全に利用するうえで、AI倫理の問題が、今後、さらに活発に議論されていくことは間違いない。